前置环境准备

hadoop:hdfs、yarn,参考

https://gengzongyuan.github.io/2019/02/15/Hadoop伪分布式部署/

jdk

- CDH版本软件下载

1

2下载网站:`http://archive.cloudera.com/cdh5/cdh/5/`

下载地址:`wget http://archive.cloudera.com/cdh5/cdh/5/hive-1.1.0-cdh5.7.0.tar.gz`

- 解压

tar -zxf hive-1.1.0-cdh5.7.0.tar.gz -C ~/app/ 配置环境变量

1

2

3

4

5

6vim ~/.bash_profile

export HIVE_HOME=/home/hadoop/app/hive-1.1.0-cdh5.7.0

export PATH=$HIVE_HOME/bin:$PATH

source ~/.bash_profile将mysql驱动上传到

/home/hadoop/app/hive-1.1.0-cdh5.7.0/lib目录中1

https://mvnrepository.com/artifact/mysql/mysql-connector-java/5.1.27

安装mysql,配置mysql(用于存放元数据信息)

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34- /home/hadoop/app/hive-1.1.0-cdh5.7.0/conf

- 建一个hive-site.xml文件

<configuration>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://11.11.11.11:3306/hiveDB?createDatabaseIfNotExist=true</v

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>ro121212ot</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>21212</value>

</property>

</configuration>

- hive-log4j.properties.template日志文件

这里串插一个知识点,hive的日志文件我们可以通过hive-log4j.properties进行配置

# 先复制一份日志配置文件

cp hive-log4j.properties.template hive-log4j.properties

# vim hive-log4j.properties

20 hive.log.dir=${java.io.tmpdir}/${user.name}

21 hive.log.file=hive.log

可以看到我们的日志文件输入到了${java.io.tmpdir}/${user.name}文件夹${java.io.tmpdir}/${user.name}默认为/tmp/username

文件名称为hive.log文件,hive启动

1

2

3

4

5

6

7hive-1.1.0-cdh5.7.0/bin/hive

which: no hbase in (/root/app/hive-1.1.0-cdh5.7.0/bin:/root/app/hadoop-2.6.0-cdh5.7.0/bin:/root/app/hadoop-2.6.0-cdh5.7.0/sbin:/root/app/jdk1.8.0_171/bin:/usr/local/sbin:/usr/local/bin:/sbin:/bin:/usr/sbin:/usr/bin:/root/bin)

Logging initialized using configuration in file:/root/app/hive-1.1.0-cdh5.7.0/conf/hive-log4j.properties

WARNING: Hive CLI is deprecated and migration to Beeline is recommended.

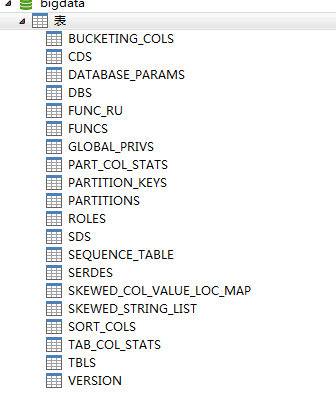

hive>此时到我们的mysql库中看下,hive已经在我们的库了建 了许多表了